aise%CC%81%20les%20marche%CC%81%20de%20l%27IA%20.png)

Le 30 Novembre 2022, OpenAI annonçait le lancement de ChatGPT, son agent conversationnel basé sur le LLM GPT. Moins d’une semaine plus tard, 5 jours pour être exact, l’application dépassait déjà le million d’utilisateurs. Un véritable raz-de-marée qui ne s’est pas arrêté. A l’heure où ces lignes sont écrites, ChatGPT compte entre 700 et 800 millions d’utilisateurs mensuels, soit près d’un humain sur dix !

A la lecture de ces chiffres, un constat semble se dessiner : ChatGPT a largement contribué à la démocratisation de l’Intelligence Artificielle, notamment auprès des particuliers. Nombreux sont ceux qui, aujourd’hui, pensent savoir réellement ce qu’est l’IA après avoir utilisé, plus ou moins intensément, le chatbot d’OpenAI.

Nous sommes pourtant bien loin du compte. ChatGPT et OpenAI ont effectivement démocratisé l’intelligence artificielle, ils l’ont même rendus mainstream. Mais cette démocratisation, si spectaculaire soit-elle, a aussi profondément biaisé la vision qu’acteurs économiques, médias et grand public ont aujourd’hui de l’IA. ChatGPT n’a pas seulement ouvert une nouvelle ère, il a imposé des raccourcis, créé des illusions et biaisé le marché global de l’IA.

Pour nous en rendre compte, nous allons identifier et tenter d’expliquer les différents biais créés par ChatGPT.

De concert avec l’essor du nombre d’utilisateurs de ChatGPT, l’IA est devenue un sujet omniprésent tant dans les médias que dans les bouches des professionnels. Une grande partie de la population s’est saisie du sujet, sans réellement savoir de quoi ils parlaient réellement.

En effet, de nombreuses voix traitent aujourd’hui l’IA dans sa globalité par le seul et unique prisme de l’IA générative et des LLMs. Pourtant, il ne s’agit là que d’une branche de l’IA et il serait extrêmement dommage de réduire l’IA et sa galaxie d’applications métiers à la seule IA générative.

L’Intelligence artificielle est bien plus vaste que cela, elle regroupe de nombreuses disciplines : vision par ordinateur, analyse prédictive, recherche opérationnelle, robotique…

Malheureusement, quand vient le temps de lancer des projets IA, de nombreux professionnels ne considèrent que l’IA générative ou GenAI, par manque de connaissances ou à cause de consultants munis d'œillères et eux-mêmes biaisés.

En se focalisant sur les LLM et l’IA générative, la majorité du marché se détourne, malgré lui, de domaines et applications moins tendances mais pourtant bien plus intéressants pour leurs activités, assurant un vrai retour sur investissement.

En lieu et place, il se concentre presque exclusivement sur des applications bureautiques.

Vous avez dit dommage ?

Quand on utilise ChatGPT, ou toute autre alternative, nous obtenons des réponses (aussi appelées prédictions en IA) sans avoir à lui présenter de données, ou lancer le moindre apprentissage. Tout ce dont l’IA a maintenant besoin, c’est d’un prompt, et c’est parti.

Il est donc assez naturel et logique de penser que l’IA, avec les LLM, se soit affranchie de cette variable.

L’adage, pas de data, pas d’IA, serait-il devenu désuet ?

Spoiler : Absolument pas.

Il faut rappeler que derrière les grands modèles de langage, les fameux LLM dont fait partie GPT, se cachent d’immenses corpus de données. Ces gigantesques bases de données servent de données d’entraînement et de validation aux LLMs, qui ne pourraient en aucun cas exister sans elles.

Par exemple, pour l’entraînement de GPT-3, le modèle derrière la première version de ChatGPT, le corpus représentait 150 fois l'entièreté de Wikipédia dans toutes les langues. C’est tout simplement énorme.

Là où le bât blesse, c’est lorsqu’un projet se construit sur ce faux constat. Le déploiement d’une application basée sur un LLM disponible est, en général, extrêmement déceptif.

Très rapidement, porteurs du projet (des entreprises ou des entrepreneurs) et utilisateurs se rendent compte que sans données propres, exploitables, adaptées et fiables, l’IA générative reste un outil de plus générique. Sans spécifications particulières sur des données représentatives, les applications de GenAI se révèlent, pour la majorité d’entre elles, inadaptées aux cas d’usages précis et spécifiques.

OpenAI a également introduit un autre biais dans le marché des professionnels de l’IA. Et celui-ci résulte d’une stratégie aussi classique qu’efficace.

De nombreux acteurs voient aujourd’hui l’Intelligence Artificielle comme un ensemble de technologies accessibles, aussi bien techniquement qu’économiquement parlant. Après tout, ChatGPT, c’est en bonne partie gratuit. Alors si une application si massivement utilisée et gratuite, ce constat doit logiquement s’appliquer à l’ensemble du secteur.

Nous sommes face à un sacré biais, et un cas d’école d’amnésie généralisée.

Comme la plupart des géants de la tech, OpenAI se trouve actuellement dans une phase d’acquisition comme l’appelle les marketeurs. OpenAI dépense énormément d’argent pour obtenir et accumuler le maximum d’utilisateurs, et plus ils ont d’utilisateurs, plus ils lèvent d’argent. Dans cette phase, la rentabilité n’intéresse pas encore les actionnaires. Le but est de capter un maximum d’utilisateurs, les rendre dépendant, puis d’augmenter progressivement, voire brutalement les tarifs. C’est une histoire qui se répète inlassablement : Netflix, Uber, Google, tous sont passés par là.

Mais il faut bien se rendre compte que le système n’est donc pas viable en l’état, et les dernières modalités d’abonnement proposées par OpenAI laissent clairement entrevoir une hausse drastique des prix. Dans un premier temps, ChatGPT était totalement gratuit, maintenant la version “Plus” coûte 23€ par mois quand la version “Pro” atteint 229€ mensuels.

Mais alors quid des startups qui ont construit un produit sur la base de ChatGPT et consort ? Quid des projets d’IA générative déployés en entreprise ? Si un business model est rentable avec la tarification actuelle, il pourrait bien y avoir une hécatombe si les prix doublent, triplent si ce n’est plus… Autre risque important, qu’OpenAI lance la même application que vous, et alors là c’est le véritable drame.

Sur les dernières années, nous avons assisté à une véritable explosion de startups et d’applications basées sur de l’IA générative, et plus particulièrement ChatGPT. Cette pullulation se caractérise tant par son volume que sa diversité.

En faisant cette observation, il paraît logique de penser que l’IA est aujourd’hui facile à développer et à déployer. Mais il ne faut pas oublier que la base est presque toujours la même : un LLM, que ce soit celui d’OpenAI, d’Anthropic ou de Mistral. Et ces LLM ont demandé un travail et des investissements colossaux.

Grâce aux progrès technologiques et aux chercheurs du monde entier, les coûts ont également baissé pour d’autres types d’applications comme celles basées sur la computer vision ou l’analyse prédictive. Mais concevoir, développer, optimiser et déployer un système d’IA performant et spécifique reste relativement onéreux.

Et ce constat s’adresse également aux projets d’IA générative qui visent des performances très élevées. Il faut s’attendre à faire de gros efforts sur les données, les différentes étapes d’optimisation des modèles, la gestion d'infrastructures complexes ou encore la cybersécurité.

Quand on parle d’intelligence artificielle, une polémique revient sans cesse : le remplacement de l’humain par les machines. Ou, pour être plus précis, le remplacement du travail humain par les machines.

Véritable serpent de mer, ce sujet polémique a été remis au goût du jour avec l'avènement de l’IA générative. En effet, nombreuses sont les multinationales à avoir annoncé la suppression de milliers d’emplois, représentant une part conséquente de leurs effectifs.

Ces annonces couplées à la nouvelle dimension créative dont fait preuve l’IA peuvent logiquement effrayer.

Toutefois, il faut là encore se montrer prudent. Ces coupes dans les effectifs sont très récentes, et un retour en arrière est toujours possible. Seul le temps permettra de dire si l’IA est capable d’être aussi efficace que les humains qu’elle a remplacé.

Si l’on se détourne de l’IA générative, la destruction créatrice chère à Schumpeter est bien plus modérée. En effet, lorsqu’une solution IA spécifique est développée, celle-ci vise une tâche bien spécifique, et en général, répétitive voire rébarbative. La part du personnel impacté est bien moins importante et l’automatisation ne touche qu'une partie, pénible, de leur travail. La reconversion et/ou la réorientation sont beaucoup plus simples à mettre en place.

L’IA, bien pensée et intégrée, transforme les métiers, reconfigure les compétences et déplace les chaînes de valeur, mais ne les efface pas purement et simplement. Ce biais entretient des peurs sociales et politiques qui obscurcissent les opportunités réelles d’augmentation humaine.

Lorsque le Deep Learning est sorti des laboratoires, de nombreuses voix se sont élevées, critiquant la consommation énergétique nécessaire à l’entraînement de modèles basés sur des réseaux de neurones artificiels profonds.

A l’époque, nous étions bien loin d’imaginer la quantité d’énergie qui serait utilisée pour entraîner les LLMs (de l’ordre du GWh), comme les ressources mobilisées pour leur utilisation au quotidien (Wh).

L’IA générative, les LLM voire les agents IA (eux mêmes principalement basés sur des LLM) consomment beaucoup d’énergie. C’est un fait. D’autant plus que la majorité des usages pourraient se passer de telles technologies. Qui n’a pas vu passer un starter pack, ou un portrait en mode studio Ghibli en 2025 ? Est ce que cela a apporté quelque chose à l'humanité, le doute est permis.

Pourtant il existe de nombreuses approches et méthodes permettant d’optimiser, de manière drastique, l’appétit énergétique des IA. Tout d’abord, un modèle de Deep Learning ne consomme presque rien pendant l’inférence pour être technique (quelques mWh) seul son entraînement consomme réellement de l’électricité (plusieurs KWh soit 100 000 fois moins qu’un LLM), mais cela n’arrive qu’une fois ! Une fois entraîné, la consommation est marginale, pour ne pas dire insignifiante.

Et pour aller plus loin, il existe également une branche de l’IA qui vise à embarquer les modèles directement sur des cibles hardware : PC, smartphone, objets connectés et micro-contrôleurs. Pour embarquer de l’IA, les modèles doivent être optimisés pour conserver un bon niveau de performance tout en consommant le moins d’énergie possible (quelques μWh).

En conclusion, l’IA consomme de l’énergie mais les ordres de grandeurs sont extrêmement éloignés en fonction des approches et technologies choisies.

Après avoir lancé ChatGPT et ouvert ses services via différentes API, OpenAI a ouvert l’accès à l’IA pour de nombreuses sociétés.

Mais cette accessibilité a aussi eu pour effet de voir naître deux nouveaux types de sociétés : des entreprises proposant des solutions IA, souvent sous forme de SaaS, qui ne sont ni plus ni moins que des wrappers, et des sociétés d’expertises en IA qui basent tout leur savoir-faire sur les technos d’OpenAI et consort.

Les premières sont certainement moins à blâmer, mais leurs durées de vie s’annoncent limitées. En effet, ces entreprises ont vu une opportunité produit, avec une application de chatGPT bien spécifique par dessus laquelle ils ont construit un produit. Malheureusement, si l’on vient à soustraire la technologie d’OpenAI, il ne reste bien souvent qu’une coquille vide.

La problème pour ces sociétés vient du manque de visibilité quant à la stratégie d’OpenAI tant d’un point de vue du pricing (quid de leur business model si les tarifs d’OpenAI vient à doubler ?) que des ambitions du géant américain. Lequel a récemment annoncé qu’il allait diversifier ses activités et s’orienter vers de nouveaux marchés avec des applications dédiées.

Pour les autres sociétés, les nouveaux experts en IA, la donne est différente. Ces acteurs font souvent plus de mal que de bien. D’une part, ils biaisent le marché de l’IA car ils sont eux même biaisés, ne disposant que d’une “expertise” extrêmement limitée et cantonnée à l’utilisation de l’IA générative. Si vous utilisez régulièrement LinkedIn, vous n’avez pas pu passer à côté de cette recrudescence d’experts IA. Une expertise qui tient jusqu’à la lecture des CV desdits experts, qui ne font que surfer sur une tendance marketing. Malheureusement, en revendiquant une expertise fallacieuse, c’est tout un marché qu’ils peuvent biaiser, voire pire, dégoûter de l’IA en prodiguant des conseils erronés et en menant des projets plus que bancals (une étude récente du MIT explique que 95% des projets d’IA générative n’apportent aucun ROI). Tout cela au détriment des véritables professionnels du secteur qui se donnent du mal pour réussir des transferts technologiques challengeant, et repousser l’état-de-l’art.

Dès le lancement de ChatGPT, les utilisateurs se sont rués sur l’application. Or cette utilisation massive ressemblait à une expérimentation grandeur nature. Et très rapidement, l’engouement a été modéré par de premiers retours négatifs et autres questionnements.

Les premières critiques proviennent des limites et hallucinations récurrentes que génèrent les LLM. Face à une question dont ils n’ont pas la réponse, ils ont tendance à inventer des faits, à “halluciner”. De l’autre côté, face à des questions très simples et actuelles, l’IA était incapable de répondre. Plusieurs exemples ont fait le buzz, comme le fait de comparer un œuf de poule à un œuf de vache, ne pas savoir réaliser des additions basiques ou encore ne pas savoir nommer le premier ministre français (il faut dire qu’entre 2024 et 2025, il y a eu pas mal de changements). Un premier couac dans la confiance que la population accorde à ces technologies. Toutefois, il est à noter que des optimisations ont été apportées et viennent corriger ces problématiques. D’une part les modèles ont été amélioré, les données d’entraînement ont été mises à jour, et la plupart des applications et modèles peuvent maintenant mener des recherches internet.

L’utilisation de ChatGPT et consort a également soulevé une autre problématique : la souveraineté et la gouvernance des données. En effet, pour interagir avec ce type d’applications, nous devons rédiger un prompt, or il est possible d’intégrer des données et informations sensibles dans ces prompts, comme ce fut le cas chez Samsung en 2023, où des employés de la division semi-conducteurs de Samsung avaient envoyé une partie du code source dans ChatGPT. Leur objectif était simple, mieux comprendre les rendements ou obtenir des informations techniques. Le problème, c’est que ce code source était maintenant entre les mains d’OpenAI.

Suite à différentes polémiques, plusieurs entreprises ont décidé de restreindre l’utilisation de la GenAI, pour lutter contre la fuite d’informations stratégiques et confidentielles. Face à cela, une nouvelle pratique est née et a même été nommée, le shadow AI. Comprenez l’utilisation de l’IA générative en sous marin sans en avoir la permission. Une pratique risquée, tant pour les collaborateurs que pour les organisations.

Tout cela ferait presque oublier que la plupart des technologies IA sont pourtant sûres et sécurisées. Il existe de nombreuses solutions déjà déployées dans le domaine de la Défense, de la Santé ou encore de la Finance. Des secteurs critiques ou les aléas et incertitudes ne sont pas permis. Un preuve que bien pensée, conçue et développée, des solutions IA évaluées et validées sont tout à fait fiables.

Depuis 2022, nous assistons à une véritable explosion d’applications ou autres plugins basés sur les LLM ce qui contribue à banaliser ce type de technologies.

De nombreuses entreprises veulent aller vite et déploient rapidement des applications proches de ce que proposent chatGPT, par facilité mais aussi par peur de rater le train de l’IA. Ces dirigeants pensent avoir passer le cap de l’IA, mais n’ont déployé, en réalité que quelques solutions bureautiques, passant à côté de réelles solutions métiers.

Or, si le déploiement de solutions IA devient trivial, les tenants et aboutissants des projets sont moins réfléchis, moins challengés et les solutions déployées n’apportent finalement que peu, voire pas, de retour sur investissement.

En résulte une vision erronée de ce que peut apporter l’IA, qui se retrouve classée dans la catégorie des technologies gadget par ces acteurs.

Pour réellement mettre l’IA au service d’une entreprise, il faut à la fois s’intéresser aux activités, métiers, enjeux et problématiques propres à cette dernière mais aussi à l’ensemble des approches et technologies que l’IA peut offrir et non pas à la seule IA générative.

ChatGPT a largement et incontestablement transformé le marché de l’IA. S’il a démocratisé l’IA et accéléré son adoption, il ne l’a pas moins biaisé. Aujourd’hui, l’intelligence artificielle est trop souvent réduite à la seule IA générative, voire à l’IA agentique. Une vision simpliste et trompeuse qui pourrait avoir des conséquences désastreuses pour tout un marché.

En effet OpenAI grandement œuvré au lancement d’une nouvelle hype qui pourrait s’avérer néfaste, celle de l’IA générative. Une branche de l’IA qui connaît un engouement jamais vu dans l’histoire de l’IA.

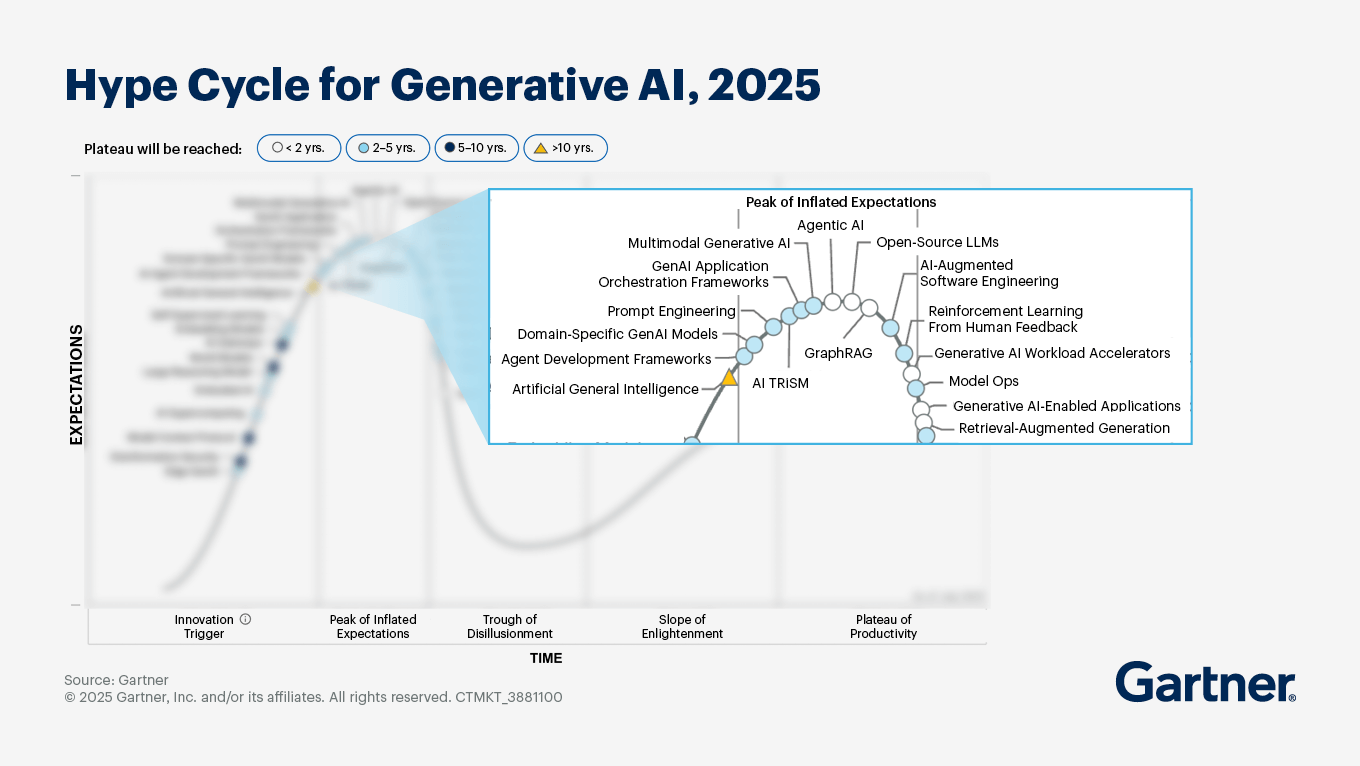

Or quand on s’intéresse à l’histoire de l’IA, nous savons que les phases d’engouement ont laissé place à des phases de désillusion proportionnelles. Et c’est justement sur ce fil que nous nous trouvons. Gartner allant dans ce sens, plaçant l’IA générative tout en haut de la courbe de hype, un état qui précède, en général, une chute brutale dans les attentes du marché.

Les professionnels et experts de l’IA ont donc un rôle majeur à jouer, et même une responsabilité, quant au fait de modérer cette tendance et redonner à l’IA sa juste définition sans quoi ils pourraient se réveiller un peu trop tard, faisant face à un marché désabusé et à l’arrêt.