L’évolution de l’intelligence artificielle est une aventure fascinante qui s’étend sur plus de sept décennies. De ses débuts visionnaires aux applications révolutionnaires actuelles, l’histoire de l’IA est jalonnée d’innovations majeures, de périodes d’espoir et de moments de doute. Cet article vous propose de retracer les grandes étapes de cette discipline en perpétuelle mutation.

Avant de plonger dans l’histoire de l’IA, il est important de préciser que l’intelligence artificielle ne se limite pas aux chatbots populaires ou aux modèles de génération de texte comme ChatGPT. L’IA englobe un large éventail de technologies, allant de la reconnaissance vocale et visuelle, aux systèmes experts, en passant par le machine learning et le deep learning. C’est un domaine multidisciplinaire mêlant informatique, mathématiques, linguistique et neurosciences.

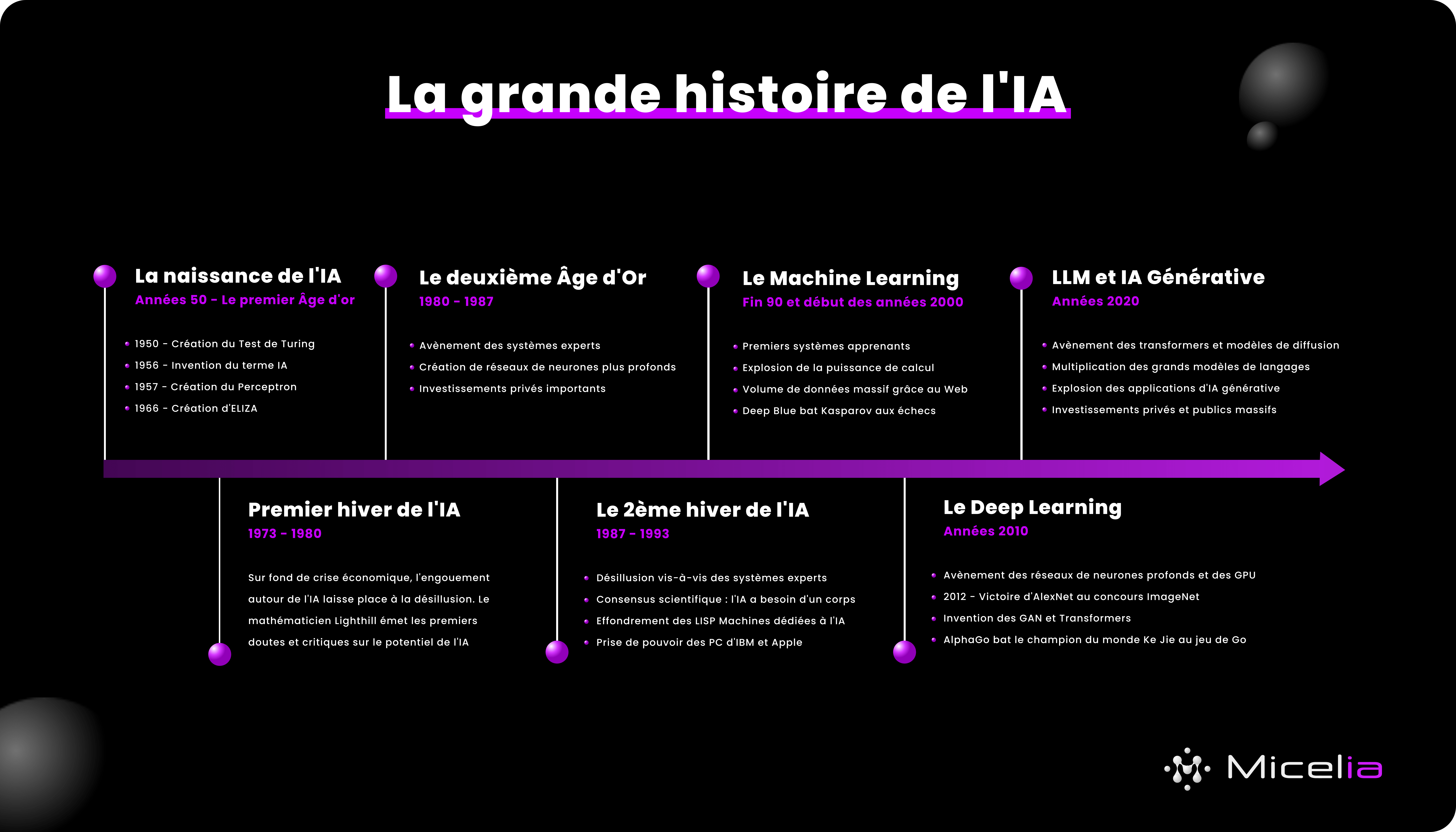

Il faut remonter en 1950 et à Alan Turing pour retrouver une première trace du concept d'intelligence artificielle. S'il n'invente pas le terme à proprement parler, Turing pose les bases du concept, et propose le premier test d'intelligence artificielle dans sa publication Computing Machinery and Intelligence. Celui qui a réussi à déchiffré Enigma pendant la Seconde Guerre Mondiale base son test sur un "jeu d'imitation" dont l'objectif est d'évaluer la faculté d'une machine à imiter la conversation humaine.

Il faut attendre 6 ans et la conférence de Darthmouth pour entendre parler, pour la première fois, du terme d'intelligence artificielle. En effet, c’est en 1956, lors de ce cette conférence, que le terme « intelligence artificielle » est officiellement introduit. Les pionniers comme John McCarthy et Marvin Minsky imaginaient alors des machines capables de raisonner, apprendre et dialoguer.

Il n'aura suffit que d'une petite année pour passer de la théorie à la pratique, puisqu'en 1957, Frank Rosenblatt invente le Perceptron, le tout premier algorithme d'apprentissage automatique supervisé de classifieurs binaires.

Près de 10 ans plus tard, nous découvrons ELIZA, développée entre 1964 et 1966 par Joseph Weizenbaum, qui simule une conversation thérapeutique avec les utilisateurs. Il s'agit là du tout premier chatbot de l'Histoire. Ou encore Dendral, le premier système expert créé en 1965 par le quatuor de scientifiques Edward Feigenbaum, Bruce Buchanan, Joshua Lederberg et Carl Djerassi.

Ces avancées initiales suscitent un enthousiasme considérable, avec l’espoir d’atteindre une intelligence intelligence comparable à celle des humains dans un futur proche. Un engouement tel que l'on nomme cette période le "1er Âge d'or" de l'IA, qui rime avec des investissements de plusieurs milliards de dollars au MIT pour résoudre les enjeux de l'IA.

La date du 30 Août 1973 est un tournant et marque un véritable coup d'arrêt. Lors de l'émission "Controversy" de la BBC, le mathématicien anglais sir James Lighthill qualifie de "mirage" les attentes et espoirs placés dans ce domaine scientifique. Dans un rapport sorti quelques mois plus tôt, le mathématicien critiquait déjà l'IA et regrettait qu'en près de 20 ans aucune découverte majeure n'ait été faite. Il s'appuie sur le fait qu'en 1973, aucune IA ne savait lire un texte manuscrit, ou même réellement capable de reconnaissance vocale, preuves, selon lui que l'Intelligence Artificielle ne pourrait jamais égaler l'intelligence humaine.

Cette prise de position médiatique, et soutenue par d'autres scientifiques, aura pour effet de réduire drastiquement les financements dans l'IA. Plongés dans une crise économique, de nombreux pays coupent les budgets alloués, comme le Royaume-Uni ou les Etats-Unis.

Il faut dire que la réalité technique rattrape rapidement l’enthousiasme. Dans les années 1970 et 1980, la complexité du langage, de la perception et du raisonnement humain dépasse les capacités des ordinateurs de l’époque.

Entre désenchantement et limitations techniques, les financements disparaissent donc, et la recherche entre dans une phase de stagnation, souvent appelée hiver de l’IA.

Il faudra attendre les années 80 et l'avènement des systèmes experts, des systèmes conçus pour reproduire le raisonnement d’un spécialiste en son domaine à base de règles codées, pour que le domaine de l'IA note un regain d’intérêt, mais leur rigidité et leur incapacité à s’adapter freinent la progression.

Les systèmes experts donnent un nouvel élan à la recherche et aux financements, comme c'est le cas au Japon et au Royaume-Uni qui investissent respectivement des milliards dans le domaine. Il est à noter que les financements, à cette époque viennent de plus en plus d'acteurs privés qui sentent le bon filon des systèmes experts.

En résulte le développement de systèmes experts, notamment dans le domaine de la médecine comme MYCIN, ou encore la création de réseaux de neurones artificiels plus profonds que leurs prédécesseurs nés durant le premier âge d'or.

Toutefois, cette période ne dure pas. La promesse portée par les systèmes experts se heurtent à la réalité. S'ils sont gages d'économies, ils se révèlent rigides et très chers à mettre à jour puisque la plupart, pour ne pas dire la totalité, des règles sont encore codées à la main. Ce nouveau désenchantement frappe le domaine de plein fouet, et nous entrons alors dans le second hiver de l'IA.

Le deuxième « hiver de l’IA », du milieu des années 1980 au début des années 1990, marque la fin de l’euphorie des systèmes experts. Chaque évolution exigeait l’ajout manuel de centaines de règles, rendant leur maintenance complexe et leur adaptation limitée. Surtout, ils étaient incapables d’apprendre par eux-mêmes.

Un consensus émerge alors : l’IA doit être ancrée dans le réel, via des capteurs et des corps robotiques, plutôt que confinée à une logique symbolique désincarnée. En parallèle, le marché du hardware bascule. Les « Lisp machines », conçues pour l’IA, s’effondrent face à l’arrivée des PC d’IBM et du Macintosh d’Apple, plus accessibles et performants. Le secteur spécialisé perd ses financements, de nombreuses entreprises ferment, et la recherche ralentit.

Toutefois, un autre phénomène mondial s'apprête à rebattre les cartes du jeu : le web. A la fin des années 90, les données issues du web sont massives et alimentent de nouveaux algorithmes et réseaux de neurones.

Le véritable tournant dans l’évolution de l’IA s’opéra avec l’essor du machine learning au début des années 2000. Cette nouvelle vague fit basculer la discipline vers une approche radicalement différente : au lieu de programmer explicitement les règles, on allait apprendre à la machine à partir des données.

Plusieurs facteurs convergèrent pour rendre ce changement possible :

Grâce à ces avancées, les systèmes d’IA commencèrent à détecter des motifs dans d’immenses ensembles de données, à généraliser des cas nouveaux, à s’adapter et à prédire. Fini l’IA basée sur des règles rigides, place à l’IA qui apprend et s’améliore sans intervention humaine constante.

Les applications pratiques se multiplièrent rapidement. On vit l’émergence de moteurs de recherche plus intelligents, de filtres anti-spam efficaces, de recommandations personnalisées sur des plateformes comme Amazon ou Netflix, ou encore de systèmes de traduction automatique capables de rivaliser avec des interprètes humains.

Si le début des années 2000 avait marqué un changement d’approche, l’année 2012 constitua un véritable tournant dans l’histoire de l’IA avec l’explosion du deep learning — ou apprentissage profond. Cette méthode repose sur des réseaux de neurones artificiels à plusieurs couches capables de modéliser des relations extrêmement complexes dans les données.

La victoire retentissante d’AlexNet lors du concours ImageNet — une compétition annuelle de reconnaissance d’images — fit sensation. AlexNet réduisit drastiquement le taux d’erreur des systèmes de vision par ordinateur, prouvant la supériorité du deep learning sur les approches traditionnelles.

Dès lors, les avancées s’accélérèrent de manière exponentielle. Les réseaux profonds permirent :

Portées par l'utilisation de GPU qui accélèrent les calculs en IA, ces avancées concrètes témoignaient d’une puissance nouvelle et d’une capacité à traiter des volumes colossaux d’informations avec une précision inédite.

Si ces systèmes restent souvent qualifiés de « boîtes noires », car leurs décisions sont difficilement explicables, ils n'en restent pas moins massivement adoptés et tout s'accélère, les événements et démonstration de force se multiplient:

L'avènement des transformers a ouvert la voie vers une ère nouvelle, celle de l'IA générative basée sur de grands modèles de langage.

Ces modèles, à l’image de GPT (OpenAI), Claude (Anthropic) ou Gemini (Google), ne se contentent plus d’analyser ou de reconnaître des données. Ils sont capables de produire du contenu original (textes, images, musiques, vidéos) à la demande, et ce, avec un réalisme impressionnant.

Leur fonctionnement repose sur des modèles de langage à très grande échelle (LLMs) entraînés sur des corpus gigantesques, qui leur permettent de saisir les nuances du langage et de générer des réponses cohérentes et parfois créatives.

Cette capacité ouvre des horizons insoupçonnés dans de nombreux domaines :

Mais cette évolution de l’IA soulève aussi des questions profondes. Qu’est-ce que la créativité quand un algorithme peut écrire un poème ou composer une symphonie ? Quelle place reste-t-il pour l’humain dans un monde où des machines peuvent simuler des dialogues complexes, inventer des histoires ou produire des œuvres artistiques ? Et surtout, comment garantir l’authenticité, la véracité et l’éthique dans ce nouveau paysage numérique ?

Il faut toutefois nuancer la créativité de ces IA et se rappeler qu'il ne s'agit que d'une nouvelle branche de l'IA pournepas réduire l'ensemble du domaine à ces seuls modèles.

L’intelligence artificielle n’est pas une invention instantanée ni un simple produit technologique. C’est une discipline complexe, façonnée par des décennies d’efforts, d’espoirs et d’erreurs. Son histoire est un véritable récit d’exploration scientifique, marqué par des phases d’euphorie et de doute, des avancées fulgurantes et des reculs nécessaires.

Aujourd’hui, l’évolution de l’IA est plus rapide que jamais, portée par des innovations comme le deep learning et les modèles génératifs, qui modifient radicalement notre rapport à la technologie, à la créativité et à la connaissance.

Comprendre cette histoire, ses cycles et ses enjeux est essentiel pour se positionner face aux défis éthiques, sociaux et économiques que pose cette révolution technologique. C’est un voyage passionnant, au cœur d’une science encore en plein chantier, qui façonne notre futur collectif.